Fakta Unik: Adopsi AI Tingkatkan Risiko Kebocoran Data, Bagaimana Pencegahannya Menurut Ensign InfoSecurity?

Adopsi teknologi AI membawa kemudahan namun juga meningkatkan risiko kebocoran data. Ensign InfoSecurity membeberkan cara mencegah risiko kebocoran data AI yang patut diwaspadai.

Perusahaan keamanan siber terkemuka, Ensign InfoSecurity, baru-baru ini menyoroti adanya peningkatan risiko kebocoran data seiring pesatnya adopsi teknologi kecerdasan buatan (AI). Meskipun AI menawarkan berbagai kemudahan dan efisiensi dalam pekerjaan, potensi kerentanan data menjadi perhatian utama bagi banyak pihak.

Hal ini disampaikan oleh Head of Consulting Ensign InfoSecurity, Adithya Nugraputra, dalam presentasi Laporan Lanskap Ancaman Siber 2025 di Jakarta Selatan pada Rabu (23/7). Menurutnya, fenomena penggunaan AI yang masif tanpa diimbangi langkah keamanan memadai dapat membuka celah bagi kebocoran informasi sensitif.

Oleh karena itu, perusahaan dan individu perlu memahami secara mendalam implikasi keamanan dari penggunaan AI. Strategi mitigasi risiko menjadi krusial untuk menjaga integritas dan kerahasiaan data di era digital yang semakin kompleks ini.

Pentingnya Klasifikasi Data dan Penggunaan LLM Terpercaya

Untuk meminimalisir risiko kebocoran data akibat adopsi AI, Ensign InfoSecurity menekankan pentingnya penerapan klasifikasi data yang ketat. Perusahaan harus secara jelas mengidentifikasi jenis data mana yang boleh diproses oleh AI dan mana yang tidak boleh disebarkan ke publik. Pendekatan ini membantu mencegah informasi sensitif jatuh ke tangan yang salah.

Selain itu, penggunaan Large Language Model (LLM) yang terpercaya dan telah melalui audit keamanan menjadi rekomendasi utama. Model bahasa besar yang kredibel umumnya memiliki mekanisme keamanan bawaan yang lebih baik. Ini mengurangi potensi kerentanan yang bisa dieksploitasi oleh pihak tidak bertanggung jawab.

Adithya Nugraputra menambahkan bahwa LLM kini dapat diinstal di lingkungan lokal (local environment) tanpa koneksi internet. Opsi ini sangat bermanfaat bagi perusahaan yang ingin menganalisis data tanpa khawatir data tersebut keluar dari jaringan internal mereka. Solusi ini memberikan lapisan keamanan tambahan untuk data sensitif.

Kebijakan Internal dan Sistem Keamanan Adaptif

Perusahaan juga disarankan untuk mengadopsi sistem keamanan canggih yang mampu menyaring konten sebelum diunggah ke layanan publik seperti ChatGPT. Mekanisme penyaringan ini memastikan bahwa tidak ada data sensitif yang secara tidak sengaja bocor ke platform eksternal. Penerapan teknologi ini menjadi benteng pertahanan pertama dalam mencegah kebocoran.

Lebih lanjut, Adithya menekankan urgensi kebijakan dan panduan internal yang jelas terkait penggunaan AI di lingkungan kerja. Panduan ini harus mengatur secara spesifik alat AI apa yang diizinkan, bagaimana cara penggunaannya yang aman, serta jenis data apa yang sama sekali tidak boleh dibagikan. Edukasi karyawan tentang pedoman ini sangat penting untuk membangun budaya keamanan data.

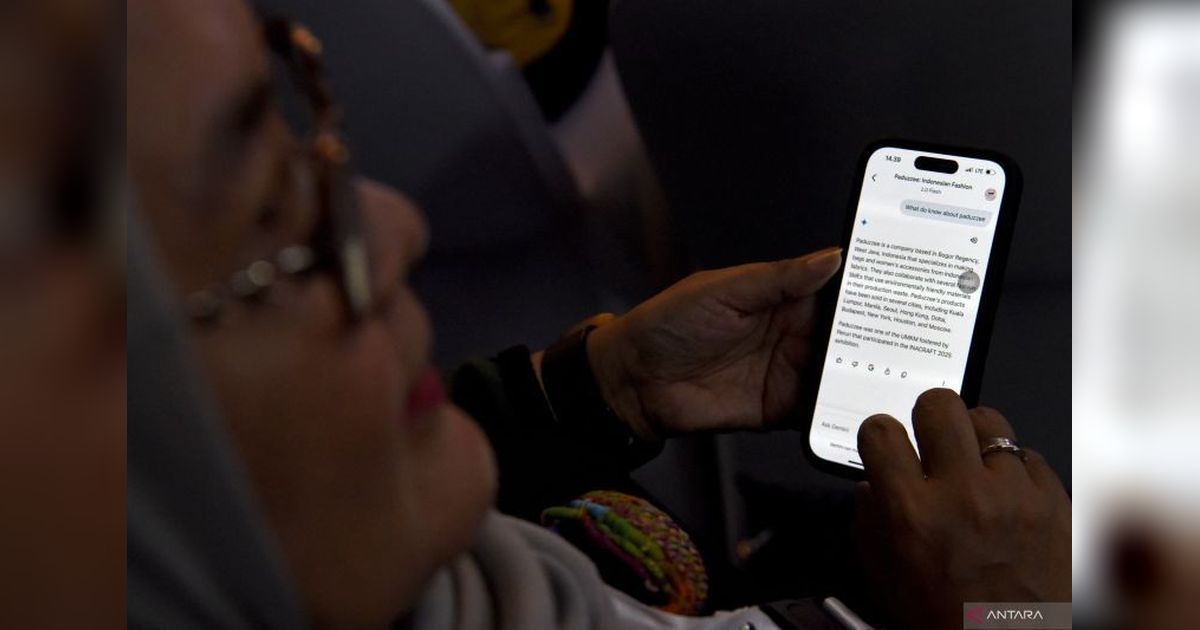

Menariknya, pelarangan total penggunaan AI tanpa pendekatan yang tepat justru bisa menjadi bumerang. Karyawan mungkin akan tetap mengakses teknologi AI melalui perangkat pribadi mereka, seperti ponsel, yang berada di luar kontrol perusahaan. Ini menciptakan "shadow IT" yang jauh lebih sulit untuk diawasi dan diamankan.

Oleh karena itu, perusahaan perlu menghormati kebutuhan karyawan yang menggunakan AI untuk meningkatkan produktivitas. Pendekatan yang lebih bijak adalah dengan memfasilitasi penggunaan AI secara aman dan terkontrol. Membatasi inovasi tanpa solusi justru dapat menghambat kemajuan bisnis secara keseluruhan.